Teknik Industri

Memanfaatkan Analisis Data: Kunci Keputusan Tepat dan Keunggulan Kompetitif

Dipublikasikan oleh Muhammad Ilham Maulana pada 18 April 2024

Analisis data melibatkan pemeriksaan, penyempurnaan, transformasi, dan pemodelan data untuk mengungkap wawasan yang berharga, menginformasikan keputusan, dan meningkatkan proses pengambilan keputusan. Analisis data mencakup berbagai teknik di berbagai bidang seperti bisnis, sains, dan ilmu sosial, yang berfungsi sebagai alat penting untuk pengambilan keputusan yang tepat dalam lanskap bisnis saat ini.

Dalam analisis data, terdapat teknik khusus seperti data mining, yang berfokus pada pemodelan prediktif dan penemuan pengetahuan, bukan hanya untuk tujuan deskriptif. Di sisi lain, intelijen bisnis menekankan pada analisis data agregat yang disesuaikan dengan kebutuhan bisnis. Aplikasi statistik lebih lanjut mengkategorikan analisis data ke dalam statistik deskriptif, analisis data eksploratori (EDA), dan analisis data konfirmatori (CDA). EDA bertujuan untuk mengidentifikasi pola baru dalam data, sedangkan CDA memverifikasi atau menyangkal hipotesis yang ada. Analisis prediktif menggunakan model statistik untuk peramalan atau klasifikasi, sementara analisis teks mengekstrak dan mengkategorikan informasi dari sumber tekstual.

Integrasi data mendahului analisis data, menyoroti pentingnya mengumpulkan dan menyiapkan data untuk analisis. Selain itu, analisis data terkait erat dengan visualisasi dan penyebaran data, meningkatkan interpretasi dan komunikasi wawasan yang berasal dari data.

Secara keseluruhan, analisis data berfungsi sebagai alat fundamental bagi organisasi, memungkinkan mereka memanfaatkan data secara efektif untuk mendorong keputusan yang tepat dan mendapatkan keunggulan kompetitif di industri masing-masing.

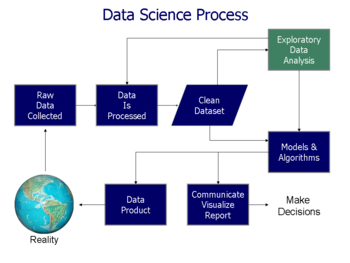

Proses analisis data

Diagram alur proses ilmu data dari Doing Data Science, oleh Schutt & O'Neil (2013).

Analisis data adalah proses memecah entitas yang kompleks menjadi komponen-komponen individual untuk diperiksa secara menyeluruh. Analisis ini melibatkan perolehan data mentah dan mengubahnya menjadi informasi berharga yang membantu pengambilan keputusan. Data dikumpulkan dan dianalisis untuk menjawab pertanyaan, menguji teori, atau menyangkal asumsi.

Pada tahun 1961, ahli statistik John Tukey mendefinisikan analisis data sebagai serangkaian prosedur dan teknik untuk menginterpretasikan hasil, merencanakan pengumpulan data, dan menerapkan metode statistik.

Proses analisis data terdiri dari beberapa tahap, masing-masing berulang dan dibangun di atas tahap sebelumnya. Kerangka kerja CRISP, yang biasa digunakan dalam penggalian data, mengikuti struktur yang serupa.

- Persyaratan Data: Fase ini melibatkan penentuan input data yang diperlukan berdasarkan tujuan analisis. Hal ini termasuk menentukan variabel yang diminati dan jenis data yang dibutuhkan.

- Pengumpulan Data: Data dikumpulkan dari berbagai sumber, seperti wawancara, sumber online, atau sensor. Analis mengomunikasikan kebutuhan data kepada kustodian yang bertanggung jawab atas pengumpulan data.

- Pengolahan Data: Setelah diperoleh, data disusun ke dalam format terstruktur, biasanya berupa baris dan kolom dalam tabel. Langkah ini memfasilitasi analisis lebih lanjut dengan menggunakan perangkat lunak.

- Pembersihan Data: Data yang telah diproses mungkin mengandung kesalahan, duplikasi, atau entri yang tidak lengkap. Pembersihan data melibatkan perbaikan masalah-masalah ini untuk memastikan keakuratan dan keandalan data.

- Analisis Data Eksplorasi (EDA): Analis menggunakan berbagai teknik untuk mengeksplorasi data dan memahami pesan yang mendasarinya. Statistik deskriptif dan visualisasi data membantu dalam mendapatkan wawasan dari data.

- Pemodelan dan Algoritma: Model dan algoritma matematika diterapkan untuk mengidentifikasi hubungan antar variabel. Statistik inferensial, seperti analisis regresi, membantu dalam memahami hubungan antara variabel-variabel tertentu.

- Produk Data: Analisis data sering kali menghasilkan pengembangan produk data, seperti aplikasi atau algoritme, yang menghasilkan output berdasarkan input data.

- Komunikasi: Data yang dianalisis disajikan kepada pengguna dalam berbagai format untuk memenuhi kebutuhan mereka. Teknik visualisasi data, seperti tabel dan bagan, membantu dalam menyampaikan pesan-pesan kunci secara efektif.

Mengungkap Pesan Kuantitatif dari Data: Panduan dan Teknik Analisis

Dalam analisis data, terdapat berbagai pesan kuantitatif yang dapat diungkap melalui berbagai teknik dan grafik. Stephen Few mengidentifikasi delapan jenis pesan kuantitatif yang dapat dipahami atau disampaikan dari sebuah set data beserta grafik yang digunakan untuk membantu komunikasi pesan tersebut. Antara lain:

- Time-series: Menunjukkan perkembangan suatu variabel dalam rentang waktu tertentu, misalnya tingkat pengangguran dalam 10 tahun terakhir.

- Ranking: Menganalisis peringkat subdivisi kategorikal, seperti peringkat kinerja penjualan dari sejumlah penjual dalam periode waktu tertentu.

- Part-to-whole: Membandingkan subdivisi kategorikal sebagai rasio terhadap keseluruhan, contohnya bagian pangsa pasar dari beberapa pesaing dalam pasar tertentu.

- Deviation: Membandingkan subdivisi kategorikal terhadap referensi, seperti perbandingan pengeluaran aktual vs anggaran untuk beberapa departemen perusahaan dalam periode waktu tertentu.

- Frequency distribution: Menampilkan jumlah observasi variabel tertentu dalam interval tertentu, seperti distribusi tahun-tahun dimana return pasar saham berada dalam interval tertentu.

- Correlation: Membandingkan observasi antara dua variabel untuk menentukan apakah mereka cenderung bergerak ke arah yang sama atau berlawanan.

- Nominal comparison: Membandingkan subdivisi kategorikal tanpa urutan tertentu, misalnya volume penjualan berdasarkan kode produk.

- Geographic or geospatial: Membandingkan variabel melalui peta atau tata letak, seperti tingkat pengangguran per wilayah atau jumlah orang di setiap lantai gedung.

Untuk memahami data secara lebih baik, ada serangkaian praktik terbaik yang direkomendasikan oleh Jonathan Koomey. Ini meliputi:

- Memeriksa data mentah untuk anomali sebelum melakukan analisis.

- Mengkonfirmasi total utama sebagai jumlah subtotal.

- Memeriksa hubungan antara angka yang seharusnya berkaitan dengan cara yang dapat diprediksi.

- Melakukan normalisasi angka untuk memudahkan perbandingan.

- Membagi masalah menjadi bagian-bagian komponen dengan menganalisis faktor yang menyebabkan hasilnya.

Analisis data juga sering melibatkan penggunaan teknik statistik seperti uji hipotesis dan analisis regresi. Uji hipotesis digunakan untuk menguji apakah suatu hipotesis tentang keadaan yang sebenarnya didukung oleh data yang ada. Sementara analisis regresi digunakan untuk menentukan seberapa besar variabel independen memengaruhi variabel dependen.

Dengan memahami pesan kuantitatif dari data dan menerapkan teknik analisis yang tepat, organisasi dapat mengambil keputusan yang lebih tepat dan memperoleh keunggulan kompetitif di pasar bisnis.

Disadur dari: en.wikipedia.org

Teknik Industri

Memahami Statistik Deskriptif: Mengungkap Rahasia Data

Dipublikasikan oleh Muhammad Ilham Maulana pada 18 April 2024

Statistik deskriptif adalah sekumpulan statistik ringkasan yang secara kuantitatif menggambarkan atau merangkum fitur dari kumpulan informasi, sedangkan statistik deskriptif merupakan proses penggunaan dan analisis statistik tersebut. Tujuan statistik deskriptif adalah untuk merangkum sampel data, bukan untuk menggunakan data tersebut untuk mempelajari populasi yang dianggap mewakili sampel data tersebut. Ini berbeda dengan statistik inferensial, yang bertujuan untuk membuat kesimpulan tentang populasi berdasarkan sampel data yang diperoleh.

Statistik deskriptif umumnya tidak dikembangkan berdasarkan teori probabilitas, dan seringkali merupakan statistik nonparametrik. Meskipun analisis data utamanya menggunakan statistik inferensial, statistik deskriptif biasanya juga disajikan. Misalnya, dalam laporan penelitian tentang subjek manusia, biasanya terdapat tabel yang mencantumkan ukuran sampel keseluruhan, ukuran sampel dalam subkelompok penting, dan karakteristik demografis atau klinis seperti usia rata-rata, proporsi subjek dari setiap jenis kelamin, proporsi subjek dengan penyakit penyerta terkait, dll.

Beberapa ukuran yang umum digunakan untuk menggambarkan kumpulan data adalah ukuran pusat dan ukuran keragaman atau dispersi. Ukuran pusat meliputi mean, median, dan mode, sedangkan ukuran keragaman meliputi standar deviasi (atau varians), nilai minimum dan maksimum variabel, kurtosis, dan skewness. Dengan memahami dan menggunakan statistik deskriptif ini, kita dapat mengungkap rahasia yang tersembunyi dalam data dan membuat kesimpulan yang lebih tepat tentang populasi yang direpresentasikan oleh sampel data tersebut.

Penggunaan Analisis Statistik

Statistik deskriptif memberikan ringkasan sederhana tentang sampel dan pengamatan yang telah dilakukan. Ringkasan tersebut dapat berupa ringkasan kuantitatif, yaitu ringkasan statistik, atau visual, yaitu grafik yang mudah dipahami. Ringkasan ini dapat menjadi dasar deskripsi awal data sebagai bagian dari analisis statistik yang lebih luas, atau dapat juga cukup untuk investigasi tertentu.

Sebagai contoh, persentase tembakan dalam bola basket adalah statistik deskriptif yang merangkum performa pemain atau tim. Angka ini adalah jumlah tembakan yang dilakukan dibagi dengan jumlah tembakan yang dilakukan. Sebagai contoh, seorang pemain yang melakukan tembakan 33% berarti melakukan sekitar satu tembakan dari setiap tiga tembakan. Persentase ini merangkum atau menggambarkan beberapa kejadian terpisah. Pertimbangkan juga indeks prestasi kumulatif. Angka tunggal ini menggambarkan kinerja umum seorang siswa di seluruh rentang pengalaman kursus mereka.

Penggunaan statistik deskriptif dan ringkasan memiliki sejarah yang panjang dan, memang, tabulasi sederhana dari populasi dan data ekonomi adalah cara pertama kali topik statistik muncul. Baru-baru ini, kumpulan teknik ringkasan telah dirumuskan di bawah judul analisis data eksplorasi: contoh dari teknik tersebut adalah plot kotak.

Dalam dunia bisnis, statistik deskriptif memberikan ringkasan yang berguna dari berbagai jenis data. Contohnya, investor dan pialang dapat menggunakan catatan historis mengenai perilaku imbal hasil dengan melakukan analisis empiris dan analitis pada investasi mereka untuk membuat keputusan investasi yang lebih baik di masa depan.

Analisis univariat

Analisis univariat melibatkan penggambaran distribusi variabel tunggal, termasuk tendensi sentral (termasuk rata-rata, median, dan modus) dan dispersi (termasuk rentang dan kuartil dari kumpulan data, dan ukuran penyebaran seperti varians dan deviasi standar). Bentuk distribusi juga dapat digambarkan melalui indeks seperti skewness dan kurtosis. Karakteristik distribusi variabel juga dapat digambarkan dalam format grafik atau tabel, termasuk histogram dan tampilan batang-dan-daun.

Analisis bivariat dan multivariat

Ketika sebuah sampel terdiri dari lebih dari satu variabel, statistik deskriptif dapat digunakan untuk menggambarkan hubungan antara pasangan variabel. Dalam hal ini, statistik deskriptif meliputi:

- Tabulasi silang dan tabel kontingensi

- Representasi grafis melalui diagram pencar

- Ukuran kuantitatif ketergantungan

- Deskripsi distribusi bersyarat

Alasan utama untuk membedakan analisis univariat dan bivariat adalah karena analisis bivariat tidak hanya merupakan analisis deskriptif sederhana, tetapi juga menggambarkan hubungan antara dua variabel yang berbeda. Ukuran kuantitatif ketergantungan meliputi korelasi (seperti r Pearson ketika kedua variabel bersifat kontinu, atau Spearman's rho jika salah satu atau keduanya tidak kontinu) dan kovarians (yang mencerminkan skala variabel diukur). Kemiringan, dalam analisis regresi, juga mencerminkan hubungan antar variabel. Kemiringan yang tidak terstandardisasi menunjukkan perubahan unit dalam variabel kriteria untuk perubahan satu unit dalam prediktor. Kemiringan terstandardisasi menunjukkan perubahan ini dalam unit terstandardisasi (z-score). Data yang sangat miring sering kali ditransformasikan dengan menggunakan logaritma. Penggunaan logaritma membuat grafik menjadi lebih simetris dan terlihat lebih mirip dengan distribusi normal, sehingga lebih mudah diinterpretasikan secara intuitif.

Disadur dari: en.wikipedia.org

Teknik Industri

Profesi di Bidang Data: Peluang Karier yang Menjanjikan di Era Digital

Dipublikasikan oleh Muhammad Ilham Maulana pada 18 April 2024

Profesi di bidang data kini tengah menjadi kebutuhan besar di banyak perusahaan. Hampir seluruh perusahaan kini membutuhkan tenaga praktisi data untuk dapat mengolah data dengan sebaik mungkin demi kemajuan bisnis.

Olahan data yang sempurna dapat mendatangkan informasi dan insight yang bermanfaat bagi kemajuan perusahaan. Oleh sebab itu, perusahaan pun rela memberikan upah besar kepada para praktisi data.

Tak heran, jika semakin tahun semakin banyak orang yang tertarik untuk bisa berkarier di dunia data. Sejalan dengan riset Kementerian Komunikasi dan Informatika RI yang menyatakan Indonesia membutuhkan setidaknya 9 juta Sumber Daya Manusia (SDM) atau talenta digital hingga tahun 2030 untuk bisa meraih manfaat maksimal dari ekosistem digital.

DQLab Universitas Multimedia Nusantara (UMN) membahas sejumlah profesi di ranah data yang bersinar di tahun 2022 dan semakin menjanjikan 5 tahun mendatang:

- Analis Data

Seorang analis data bertanggung jawab untuk mengumpulkan, memproses, melaporkan, dan memvisualisasikan data sebagai kesimpulan. Mereka juga memanipulasi database dan melakukan analisis statistik serta interpretasi data. Keterampilan yang diperlukan termasuk penggunaan alat seperti spreadsheet, Google Analytics, SQL, dan Tableau, serta pemahaman dasar dalam bahasa pemrograman, visualisasi data, dan statistika.

- Data Scientist

Profesi ini berperan membuat prediksi berdasarkan pola dari kumpulan data yang berasal dari masa lalu dan sekarang, kemudian data akan diolah dan dianalisis sampai menghasilkan informasi. Bisa dikatakan, Data Scientist lebih ke arah hal teknis seputar data, yang mana tugasnya meliputi perencanaan strategis untuk analisis data, melakukan data preprocessing dan visualisasi data. Seorang Data Scientist dituntut memiliki beberapa skill set, seperti statistika dan analytical skill, data mining, algoritma machine learning and deep learning, bahasa pemograman Python & R, serta komunikatif dalam menyampaikan hasil melalui visualisasi data. rapihkan tapi jangan rubah teks

- Data Engineer

Profesi ini melibatkan penanganan data mentah dengan menggunakan pengetahuan logis dan dasar database. Insinyur data bertanggung jawab atas infrastruktur data di perusahaan, termasuk membangun data warehouse dan mempersiapkan data untuk digunakan oleh ilmuwan data dan analis data. Keterampilan yang dibutuhkan mencakup ETL, pemodelan data, data warehousing, manipulasi data dengan SQL dan NoSQL, serta visualisasi data.

- Intelijen Bisnis

Dengan adanya profesi ini, perusahaan dapat menentukan langkah yang tepat berdasarkan fakta data yang sudah diolah sehingga menghasilkan kesimpulan. Business Intelligence merupakan gabungan antara business analytics, data mining, dan data visualization. Secara umum, perannya adalah meninjau data pelanggan yang telah dikumpulkan, mengawasi penyebaran data ke data warehouse, serta mengembangkan kebijakan dan prosedur untuk pengumpulan data dan analisis data. Skill set yang harus dikuasai untuk berkarier menjadi Business Intelligence, yang pertama kemampuan analisis data agar dapat melihat relevansi dan makna dari banyaknya data mentah. Ilmu komunikasi tak kalah penting, skill ini dibutuhkan saat kamu mempresentasikan hasil visualisasi data kamu serta yang terakhir adalah pengetahuan di bidang industri.

- Analisis Bisnis

Pada dasarnya, business analytics juga memiliki peran penting ketika perusahaan berbicara soal big data. Sederhananya, business analytics adalah pendekatan yang dapat dimanfaatkan untuk akses dan eksplorasi data perusahaan. Tujuannya tidak lain untuk menggali wawasan baru yang dapat meningkatkan rencana bisnis dan kinerja perusahaan. Oleh sebab itu, business analytics disebut sebagai pelengkap kehadiran business intelligence. Jika mereka dapat berjalan secara bersamaan, makan bisa menginterpretasikan data sebaik mungkin dalam memprediksi apa yang akan terjadi berdasarkan data. Business analytics juga dapat membantu dalam menyusun strategi, mengenal peluang pasar, menunjukkan potensi risiko, dan lain semacamnya.

Sumber: edukasi.kompas.com

Teknik Industri

Peningkatan Populeritas Big Data, Industri Mengincar SDM dengan Kualifikasi Data Science

Dipublikasikan oleh Muhammad Ilham Maulana pada 18 April 2024

JAKARTA, KOMPAS.com – Pernahkah Anda bertanya bagaimana media sosial merekomendasikan artikel, web page, atau user lain untuk diikuti? Atau, barangkali Anda pernah mendapati iklan tentang barang yang secara kebetulan dibutuhkan muncul tiba-tiba saat sedang asyik mengulik foto maupun video di media sosial Instagram? Jika iya, berarti Anda sedang merasakan sendiri bagaimana teknologi digital mengubah pola advertising saat ini. Hal-hal tersebut bisa terjadi berkat fenomena big data yang saat ini digunakan oleh perusahaan digital. Seiring kemunculan berbagai platform tempat berbagi konten foto, teks, video, dan data diri, data pribadi pun sudah tak menjadi hal yang sifatnya privasi di era ini.

Jumlah data ini luar biasa banyak sehingga dapat dikelola dengan baik untuk berbagai kepentingan, termasuk dalam bidang bisnis. Head of Data Science Program Bina Nusantara (Binus University) Alexander Gunawan mengatakan, perkembangan teknologi yang semakin pesat membuat hampir semua perusahaan memiliki dan dapat memanfaatkan big data, baik yang bersifat publik maupun privat. “Di Indonesia, semakin banyak perusahaan berbasis teknologi informasi (TI) seperti start-up yang berjalan secara online menggunakan data digital,” kata Alexander saat diwawancara Kompas.com, Kamis (26/11/2020). Alex juga mengatakan, big data tidak hanya dapat dimanfaatkan untuk kepentingan bisnis perusahaan teknologi, tetapi juga bidang lain mulai dari pemerintahan, perbankan, aktuaria (asuransi), konsultan jasa statistik, telekomunikasi, industri pabrik, pemasaran, industri kimia dan farmasi, hingga riset kesehatan.

Gunanya bermacam-macam. Di bidang pemerintahan misalnya, big data digunakan untuk mempercepat pengambilan keputusan, monitoring, dan evaluasi. Sementara di perbankan, big data dapat digunakan untuk meminimalisasi terjadinya kredit bermasalah dan kerugian bank, serta sebagai basis informasi mengenai rekam jejak debitur dalam aktivitas bisnis sehari-hari. Alexander menjelaskan, untuk mengambil, menyimpan, dan menganalisis data-data digital, diperlukan keilmuan data science dengan sumber daya manusia (SDM) yang kompeten dalam bidang ini. Dengan mengoptimalisasi data-data tersebut, lanjut Alexander, perusahaan dapat memperbaiki sekaligus meningkatkan layanan kepada konsumen.

“Jika (perusahaan) tidak mengacu pada data dan melihat perkembangan tren selera customer, mereka tidak dapat mengembangkan aplikasi maupun layanan yang relevan dengan kebutuhan konsumen,” jelasnya. Karenanya, lanjut dia, perusahaan perlu melakukan upgrading skill data analis SDM sehingga karyawan mahir sebagai data scientist.

Kebutuhan vital SDM data science

Di Indonesia, SDM dengan kompetensi data science masih kurang. Untuk mengisi kesenjangan (gap) terhadap kebutuhan tersebut, kata Alex, perusahaan melakukan upgrading SDM yang sudah ada lewat training (pelatihan) dari pihak ketiga. "Dengan begitu, SDM yang sudah ada bisa dimanfaatkan untuk mengolah data," kata Alex.

Meski demikian, menurutnya, akan lebih efektif jika perusahaan tetap memiliki karyawan yang memiliki disiplin ilmu data science. Hal ini memudahkan mereka jika ingin mengolah data, membaca proyeksi bisnis, dan mengambil keputusan. "Makanya, kalau misal di perusahaan ada yang berlatar belakang pendidikan data science, orang-orang ini biasanya yang dijadikan pimpinan divisi," tambahnya.

Sebagai pimpinan divisi, kata Alex, SDM potensial tersebut berperan untuk menyeragamkan kompetensi data science anggota divisi yang berasal dari berbagai latar belakang pendidikan, seperti ekonomi, informatika, maupun matematika. Kebutuhan akan SDM dengan disiplin ilmu data science juga diungkap Alex lewat publikasi World Economic Forum 2020 berdasarkan survei "Future of Job Report 2018". Di situ disebut bahwa data analyst dan data scientist menjadi peringkat pertama dari 10 pekerjaan paling bertumbuh pada 2022.

Alex memaparkan, keahlian dari disiplin ilmu ini memang akan terus dibutuhkan. Apalagi, imbuh Alex, di masa mendatang, ilmu data science semakin berkembang diikuti dengan jumlah data yang lebih besar. Keilmuan data science yang bersifat dinamis menurut Alexander juga menjadi tantangan tersendiri.

Seiring laju teknologi yang semakin cepat, keahlian SDM harus diperbaharui setiap tahun. “Tahun ini pakai program apa, tahun depan (sudah) ganti program lain yang lebih relevan,” urainya. Di sisi lain, ilmu data science membutuhkan pengetahuan dasar yang kuat dalam bidang matematika dan statistik sebagai dasar kemampuan analis. Ia menilai, dua hal tersebut menjadi salah satu tantangan dalam menyiapkan SDM yang relevan.

Mempersiapkan SDM Kompeten

Merespons kebutuhan industri terhadap SDM dengan kompetensi data science, Bina Nusantara (Binus) University menyediakan program studi strata 1 (S1) Data Science. Program Data Science merupakan bagian dari School of Computer Science yang terakreditasi A. Program studi ini mempelajari semua jenis data yang dihasilkan oleh proses bisnis dan operasional perusahaan.

Kemudian, dianalisis menggunakan teknik mining data (penambangan data) untuk memahami bagaimana kinerja suatu bisnis dan untuk mengidentifikasi peluang yang baru. Adapun program ini dirancang untuk memberikan mahasiswa keterampilan programming software development, machine learning, proses riset, dan domain knowledge berdasarkan kasus dari berbagai bidang.

“(Seorang) data scientist sebenarnya seperti ‘detektif’. Mereka harus punya kemampuan untuk memecahkan persoalan dan memberikan solusi. Skill utama ‘detektif’ adalah mengumpulkan data, kemudian menganalisis data, mencari hubungan antara setiap fakta sehingga menghasilkan suatu insight atau solusi. Itu skill utamanya,” papar Alexander.

Dalam proses belajar, lanjut dia, kalkulus dan statistik menjadi pelajaran fundamental untuk melakukan interpretasi data. Ketika berhadapan dengan data, terutama data yang detail dan ingin melakukan interpretasi hubungan variabel, ilmu statistik menjadi kunci. “Ketika jumlah data (yang dianalisis) sangat besar atau disebut big data atau mahadata, program studi Data Science mempelajari machine learning untuk mengolah data atau mencari pola data sehingga modelnya bisa digunakan untuk melakukan prediksi,” jelasnya.

Kemampuan lain yang juga harus dimiliki seorang lulusan Program Data Science adalah komunikasi. Kata Alex, solusi atau data yang telah diolah pada akhirnya akan disajikan dalam bentuk presentasi pada stakeholder. Di bagian ini, mereka harus cakap berkomunikasi, bahkan harus pintar storytelling. Alex menyebut, khusus di Binus, lulusan Program Data Science dipersiapkan untuk mampu bekerja di dunia industri.

Karenanya, mahasiswa program tersebut dibekali portofolio sejumlah kasus untuk dipecahkan. “Bila mahasiswa yang punya minat pada teknologi, mereka bisa mengambil data-data maupun kasus yang berkaitan dengan teknologi. Bila tertarik pada bidang bisnis, (mereka) bisa mengambil data-data yang berkaitan dengan bisnis seperti data transaksi,” imbuhnya. Dengan portofolio tersebut, perkembangan skill mahasiswa bisa diketahui berdasarkan studi kasus yang telah dikerjakan.

Persiapan lain yang dilakukan agar mahasiswa siap berhadapan langsung dengan pelaku industri atau masyarakat adalah 3+1 Enrichment Program. Program ini berlangsung selama 2 semester atau sebanyak 32 SKS yang dimulai dari semester 5 atau 6 sampai semester 7. Selama setahun, mahasiswa akan belajar di luar lingkungan kampus dan menimba ilmu dari perusahaan-perusahaan multinasional atau global.

Tujuan program ini adalah memberi kesempatan pada mahasiswa untuk terjun lebih awal ke dunia kerja. Dengan cara itulah, mahasiswa lebih siap bersaing. “Dalam 3+1 Enrichment Program, ada 5 jalur yang dapat dipilih mahasiswa, antara lain magang di industri, proyek riset, magang di luar negeri, entrepreneurship, dan kuliah kerja nyata (KKN),” terangnya.

Sumber: kompas.com

Teknik Industri

Definisi Menggali Pengetahuan dengan Data Mining

Dipublikasikan oleh Muhammad Ilham Maulana pada 18 April 2024

Definisi, karakteristik, dan manfaat

Definisi data mining, secara sederhana, adalah istilah yang digunakan untuk menjelaskan proses pencarian atau penambangan knowledge dari data yang sangat besar. Menurut analogi, orang mungkin berpikir bahwa istilah data mining adalah sesuatu yang tidak tepat; menambang emas dari bebatuan atau lumpur diacu sebagai ‘penambangan emas’ dan bukannya penambangan ‘batu’ atau ‘lumpur’.

Jadi, data mining barangkali lebih cocok diberi nama ‘knowledge mining’ atau ‘knowledge discovery’. Meskipun ada ketidakcocokan antara makna dan istilah, data mining telah menjadi pilihan bagi komunitas ilmu ini. Banyak nama-nama lain yang ter-asosiasi dengan data mining antara lain ‘knowledge extraction’, ‘pattern analysis’, ‘data archaeology’, ‘information harvesting’, ‘pattern searching’, dan ‘data dredging’.

Secara teknis, data minig adalah proses yang memanfaatkan teknik-teknik statistik, matematika, dan kecerdasan buatan untuk mengekstrak dan mengidentifikasi informasi dan knowledge selanjutnya (atau pola-pola) yang berasal dari sekumpulan data yang sangat besar. Berbagai macam pola tersebut bisa dalam bentuk aturan bisnis, kesamaan-kesamaan, korelasi, trend, atau model-model prediksi.

Kebanyakan literatur mendefinisikan data mining sebagai “proses yang rumit untuk mengidentifikasi pola-pola yang valid, baru, memiliki potensi bermanfaat, dan bisa dipahami, terhadap data yang disimpan di dalam database yang terstruktur”, dimana data diorganisir dalam baris-baris yang terstruktur menurut kategori, ordinal/berurutan, dan variable-variabel yang berkesinambungan. Dalam definisi ini, beberapa arti dari kata-kata kunci di atas adalah seperti berikut:

- Proses: artinya data mining terdiri dari banyak langkah perulangan Rumit: artinya bahwa ada suatu dugaan/kesimpulan atau pencarian yang berbasis eksperimentasi yang dilibatkan; yang artinya bahwa, itu bukanlah suatu hal yang mudah seperti komputasi terhadap suatu kuantitas yang sudah ditetapkan sebelumnya

- Valid: artinya bahwa pola-pola yang ditemukan seharusnya tetap benar bila diterapkan pada data yang baru dengan tingkat kepastian yang tinggi

- Baru: artinya bahwa pola-pola tidaklah diketahui sebelumnya oleh pengguna dalam konteks sistem yang sedang dianalisa

- Berpotensi bermanfaat: artinya adalah bahwa pola-pola yang ditemukan harus membawa manfaat bagi pengguna atau pada pekerjaan

- Dapat dipahami: artinya bahwa pola harus masuk akal secara bisnis yang membuat pengguna berkata “mmmm! Ini masuk akal; mengapa saya tidak memikirkan hal itu” .

Data mining bukanlah disiplin ilmu baru, tetapi lebih pada definisi yang baru untuk pemanfaatan banyak disiplin ilmu. Data mining diposisikan erat di irisan berbagai disiplin ilmu, termasuk statistik, artificial intelligence (kecerdasan buatan), machine learning, management science, information systems (sistem informasi), dan database. Lihat gambar di bawah ini:

Dengan menggunakan perkembangan di semua disiplin itu, data mining berusaha membuat perkembangan dalam mengekstrak informasi dan knowledge dari database yang besar. Ini adalah bidang ilmu yang muncul ke permukaan dan menarik banyak perhatian dalam waktu yang singkat.

Berikut adalah karakteristik utama dan tujuan dari data mining:

- Data seringkali terkubur dalam database yang sangat besar, yang terkadang berisi data selama bertahun-tahun. Dalam banyak kasus, data dibersihkan dan disatukan ke dalam data warehouse.

- Environment data mining pada umumnya adalah arsitektur client-server atau arsitektur sistem informasi berbasis web.

- Berbagai tool baru yang canggih, termasuk berbagai tool visualisasi yang canggih, membantu untuk mengangkat biji informasi yang terkubur dalam file-file korporat atau record-record arsip. Untuk mendapatkannya akan melibatkan memoles dan mensinkronisasikan data untuk mendapatkan hasil-hasil yang tepat. Data miners yang mutakhir juga memeriksa kemanfaatan data (misalnya, teks yang tak terstruktur yang disimpan dalam tempat-tempat seperti database Lotus Notes, file-file teks di internet, atau intranet korporat).

- Si penambang seringkali adalah end-user, yang didukung dengan ‘bor-bor data’ dan berbagai tool query handal lainnya untuk menanyakan pertanyaan-pertanyaan dengan tujuan tertentu dan mendapatkan jawaban-jawaban dengan cepat, dengan sedikit atau bahkan tanpa skill pemrograman sekalipun.

- Dalam menemukan pola seringkali menemukan hasil yang tak diharapkan dan meminta end-user untuk berpikir secara kreatif dalam menjalankan proses, termasuk interpretasi terhadap temuan.

- Banyak tool data mining siap dikombinasikan dengan berbagai spreadsheet dan tool development software lainnya. Jadi, data yang ditambang bisa dianalisa dan diterapkan dengan cepat dan mudah.

- Karena jumlah data yang sangat besar dan usaha pencarian yang massif, kadang-kadang perlu menggunakan pemrosesan parallel untuk data mining.

Perusahaan yang secara efektif memanfaatkan tool-tool dan teknologi data mining bisa mendapatkan dan mempertahankan keunggulan kompetitif strategis. Data mining menawarkan perusahaan suatu environment yang sangat diperlukan untuk meningkatkan keputusan untuk memanfaatkan peluang-peluang baru dengan mentransformasikan data menjadi senjata yang strategis.

Sumber: binus.ac.id

Teknik Industri

Seni dan Sains di Balik Visualisasi Data: Komunikasi Visual Modern untuk Analisis Informasi

Dipublikasikan oleh Muhammad Ilham Maulana pada 03 April 2024

Visualisasi data telah menjadi salah satu metode komunikasi visual modern yang sangat penting dalam berbagai bidang ilmu. Meskipun tidak secara eksklusif terkait dengan satu bidang tertentu, visualisasi data merupakan interpretasi antara banyak bidang, seperti statistik, ilmu komputer, dan pengembangan perangkat lunak. Tujuan utamanya adalah untuk mengkomunikasikan informasi dengan jelas dan efisien kepada pengguna melalui berbagai grafik informasi, seperti tabel dan grafik.

Seni dan sains berpadu dalam visualisasi data, di mana desain estetis dan fungsionalitas harus seimbang untuk memberikan wawasan yang intuitif terhadap data yang kompleks. Namun, terkadang desain visual yang menawan gagal dalam menyampaikan informasi dengan efektif.

Dalam era big data saat ini, tantangan dalam pemrosesan, analisis, dan komunikasi data semakin meningkat. Ilmu data dan para ilmuwan data muncul sebagai solusi untuk mengatasi tantangan tersebut. Visualisasi data secara dekat berkaitan dengan grafik informasi, visualisasi informasi, visualisasi ilmiah, eksplorasi analisis data, dan grafik statistis. Ini telah menjadi wilayah penelitian, pengajaran, dan pengembangan yang aktif pada milenium baru.

Mengungkapkan Keefektifan Tampilan Grafik dalam Komunikasi Informasi

Dalam era di mana informasi berlimpah, kemampuan untuk menyajikan data dengan jelas dan efektif melalui grafik adalah keterampilan yang sangat berharga. Professor Edward Tufte, seorang pakar dalam bidang visualisasi informasi, menekankan pentingnya prinsip-prinsip yang mendasari tampilan grafik yang efektif.

Pertama-tama, sebuah tampilan grafik harus mampu menampilkan data dengan jelas, memungkinkan pemirsa untuk dengan mudah menganalisis dan memahami informasi yang disajikan. Ini mengharuskan grafik untuk menghindari pengelabuan atau distraksi yang dapat mengaburkan pesan yang ingin disampaikan oleh data.

Selain itu, grafik yang efektif juga mendorong pengamat untuk fokus pada substansi dari data, bukan pada aspek-aspek teknis seperti desain grafik atau metodologi produksinya. Hal ini memastikan bahwa grafik tidak hanya sekadar hiasan visual, tetapi alat yang bermakna dalam menyampaikan informasi yang berguna.

Tufte juga menekankan pentingnya memaksimalkan efisiensi tampilan grafik dengan memberikan banyak informasi dalam ruang yang terbatas. Ini berarti mengurangi tinta-tinta yang tidak berkaitan dengan data serta menyajikan kumpulan data dalam format yang koheren dan mudah dipahami.

Sebagai contoh konkret, Tufte mencatat diagram Minard yang memvisualisasikan kekalahan tentara Napoleon pada tahun 1812-1813 sebagai salah satu contoh terbaik dari tampilan grafik yang efektif. Diagram ini berhasil menggabungkan beberapa variabel dalam dua dimensi dengan jelas dan menggambarkan narasi yang dapat dipahami dengan mudah.

Namun, tidak mematuhi prinsip-prinsip tampilan grafik yang efektif dapat menghasilkan apa yang disebut sebagai "sampah-grafik", di mana pesan yang ingin disampaikan oleh data menjadi kabur atau bahkan menyesatkan. Oleh karena itu, penting bagi pembuat grafik untuk mempertimbangkan secara hati-hati bagaimana mereka menyajikan informasi agar tidak mengganggu pesan yang ingin disampaikan.

Terakhir, praktik terbaik dalam menampilkan grafik, seperti yang disarankan oleh Congressional Budget Office, adalah untuk mengenali audiens yang dituju, merancang grafik yang dapat berdiri sendiri di luar konteks laporan, dan memastikan bahwa pesan kunci dapat dengan jelas disampaikan melalui grafik tersebut.

Pesan Kuantitatif

Stephen Few, penulis, mengidentifikasi delapan tipe pesan kuantitatif yang sering digunakan dalam analisis data dan komunikasi menggunakan grafik. Ini adalah:

- Rangkaian-waktu: menunjukkan perubahan suatu variabel dalam sebuah periode waktu, seperti laju pengangguran selama 10 tahun. Grafik baris dapat digunakan untuk menunjukkan tren ini.

- Peringkat: menunjukkan pembagian kategoris yang diperingkatkan secara terurut, seperti penjualan berdasarkan kategori penjual (dengan setiap penjual sebagai pembagian kategoris) selama satu periode tunggal. Grafik batang dapat digunakan untuk memperlihatkan perbandingan antara penjual.

- Sebagian-untuk-keseluruhan: menunjukkan pembagian kategoris sebagai sebuah rasio terhadap keseluruhan, seperti persentase kepemilikan saham direpresentasikan oleh kompetitor dalam sebuah pasar. Grafik lingkaran atau grafik batang dapat memperlihatkan perbandingan rasio, seperti kepemilikan saham.

- Deviasi: menunjukkan pembagian kategoris dibandingkan dengan sebuah referensi, seperti perbandingan pengeluaran aktual terhadap anggaran untuk beberapa departemen dari sebuah bisnis pada periode waktu tertentu. Grafik batang dapat memperlihatkan perbandingan nilai aktual terhadap jumlah yang diacu.

- Distribusi frekuensi: menunjukkan jumlah observasi dari variabel tertentu terhadap rentang waktu tertentu, seperti jumlah tahun di mana pasar saham menguntungkan adalah antara interval seperti 0-10%, 11-20%, dll. Histogram, tipe grafik batang, dapat digunakan untuk analisis ini.

- Korelasi: menunjukkan perbandingan antara observasi yang direpresentasikan oleh dua variabel (X, Y) untuk menentukan apakah mereka condong bergerak ke arah yang sama atau berlawanan. Sebagai contoh, memplotkan pengangguran (X) dan inflasi (Y) untuk sampel beberapa bulan. Scatter plot biasanya digunakan untuk menyampaikan pesan tersebut.

- Perbandingan nominal: menunjukkan pembagian kategoris tanpa urutan tertentu, seperti jumlah penjualan berdasarkan kode produk. Grafik batang dapat digunakan untuk pembandingan ini.

- Geografis atau geospasial: menunjukkan perbandingan dari sebuah variabel di peta atau letak, seperti laju pengangguran berdasarkan negara bagian atau jumlah orang pada lantai di sebuah bangunan. Bagan yang digunakan biasanya adalah sebuah cartogram.

Analisis data dapat meninjau beberapa atau semua pesan dan tipe grafik di atas untuk digunakan dalam pekerjaan atau penonton mereka. Proses uji coba untuk mengidentifikasi keterkaitan dan makna pesan pada data adalah bagian dari eksplorasi analisis data.

Persepsi Visual dan Visualisasi Data

Persepsi visual adalah aspek penting dari kognisi manusia yang memungkinkan kita membedakan panjang dua garis, orientasi, dan pola warna tanpa upaya pemrosesan yang signifikan. Kemampuan untuk mengenali perbedaan berdasarkan atribut pra-perhatian dikenal sebagai "pemrosesan pra-perhatian". Misalnya, manusia dapat dengan mudah membedakan panjang dua garis tanpa banyak usaha kognitif, namun mengidentifikasi berapa kali angka "5" muncul dalam sekelompok angka mungkin memerlukan lebih banyak perhatian dan pemrosesan.

Visualisasi data yang efektif memanfaatkan pemrosesan pra-perhatian dan kekuatan relatif dari berbagai atribut. Misalnya, manusia dapat dengan cepat memproses perbedaan panjang garis saat menggunakan diagram batang (yang memanfaatkan panjang garis untuk menunjukkan perbandingan) dibandingkan diagram lingkaran (yang menggunakan luas permukaan).

Terminologi

Visualisasi data mengikuti terminologi tertentu, beberapa di antaranya berasal dari statistik. Misalnya, Stephen Few mendefinisikan dua jenis data, yang digunakan secara kombinasi untuk mendukung analisis atau visualisasi yang bermakna:

1. Kategori: Label teks mendeskripsikan sifat data, seperti "Nama" atau "Usia". Kategori ini mencakup data kualitatif (bukan angka).

2. Kuantitatif: Pengukuran numerik, seperti "25" yang mewakili usia dalam tahun.

Dua Jenis Utama Penyajian Informasi Adalah Tabel Dan Bagan

- Tabel

Tabel berisi data kuantitatif yang disusun dalam baris dan kolom dengan label kategorikal. Biasanya digunakan untuk menampilkan data numerik. Dalam contoh di atas, sebuah tabel mungkin memiliki label kategorikal untuk nama (variabel kualitatif) dan usia (variabel kuantitatif), dengan setiap baris mewakili individu (unit eksperimen atau kategori dari sampel).

- Bagan

Bagan biasanya menampilkan data kuantitatif dan mewakili nilai yang dikodekan sebagai objek visual (seperti garis, batang, atau titik). Nilai numerik ditampilkan dalam wilayah yang diwakili oleh satu atau lebih sumbu. Sumbu memberikan skala (kuantitatif dan kategorikal) untuk memberi label dan memberikan nilai pada objek visual. Banyak bagan juga disebut sebagai grafik.

Perpustakaan KPI telah mengembangkan tabel periodik interaktif metode visualisasi, yang menampilkan berbagai metode visualisasi data. Ini mengikuti tujuh jenis metode visualisasi data: data, informasi, konsep, strategi, metafora, dan kombinasi.

Contoh diagram digunakan pada visualisasi data

Nama Visual Dimensi:

Dimensi Jaringan:

- Ukuran nodes

- Warna node

- Ketebalan ikatan

- Warna ikatan

- Spasialisasi

Grafik Batang:

- Panjang

- Warna

- Waktu

Streamgraph:

- Lebar

- Warna

- Waktu (alur)

Treemap:

- Ukuran

- Warna

Gantt Chart:

- Warna

- Waktu (alur)

Scatter Plot (3D):

- Posisi x

- Posisi y

- Posisi z

- Warna

Beragam Pendekatan dalam Visualisasi Data

Dalam dunia visualisasi data, terdapat beragam pendekatan yang memperluas cakupan pemahaman kita tentang bagaimana informasi dapat disajikan dengan cara yang efektif dan bermakna. Salah satu pendekatan yang umum adalah fokus pada presentasi informasi, seperti yang diuraikan oleh Friedman (2008). Friendly (2008) juga menyoroti dua aspek utama dari visualisasi data: grafik statistik dan kartografi tematik.

Namun, ada pandangan lain yang membagi ruang lingkup visualisasi data menjadi berbagai subjek yang berbeda, seperti yang diungkapkan dalam artikel "Data Visualization: Modern Approaches" (2007). Di antara subjek-subjek tersebut termasuk menampilkan koneksi antara data, menyajikan data dengan jelas, menggambarkan berita melalui visualisasi, serta menciptakan representasi visual yang dapat diakses oleh pengguna.

Dari perspektif ilmu komputer, Frits H. Post (2002) memberikan pemahaman yang lebih terinci dengan mengkategorikan bidang ini menjadi beberapa sub-bidang. Ini termasuk visualisasi informasi, teknik interaksi dan arsitektur, teknik pemodelan, metode multiresolusi, algoritme, dan teknik visualisasi, serta visualisasi volume.

Ketika kita memeriksa berbagai pendekatan ini, kita dapat melihat bagaimana visualisasi data memiliki banyak dimensi dan kompleksitas. Ini menunjukkan bahwa ada berbagai cara untuk mendekati dan memahami bagaimana data dapat disajikan dan dimanfaatkan secara optimal. Dengan memahami keragaman perspektif ini, kita dapat lebih memperkaya pemahaman kita tentang kekuatan visualisasi data dalam menyampaikan informasi dengan jelas dan bermakna.

Memahami Arsitektur Presentasi Data: Menyajikan Pengetahuan dengan Efektif

Arsitektur Presentasi Data (APD) merupakan sekumpulan keahlian yang bertujuan untuk mengelola, menyusun, dan menyajikan data dengan cara yang optimal untuk mengkomunikasikan makna dan memberikan pengetahuan kepada pengguna. Sejarah APD mengaitkan istilah ini dengan Kelly Lautt, yang menggambarkan APD sebagai kunci untuk sukses dan nilai dalam Intelijensi Bisnis.

APD menggabungkan ilmu angka, statistik, visualisasi data, komunikasi, psikologi organisasi, dan manajemen perubahan untuk menghasilkan solusi intelijensi bisnis yang dapat dimengerti. Ini bukan hanya tentang teknologi informasi atau bisnis semata, tetapi merupakan keahlian terpisah yang mencakup pemilihan data, waktu penyampaian, format, dan visualisasi yang efektif.

Tujuan utama dari APD adalah menggunakan data untuk menyediakan pengetahuan dengan cara yang efisien dan efektif. Ini meliputi meminimalkan kebisingan dan kompleksitas data yang tidak diperlukan, sambil menyediakan data yang relevan dan komprehensif untuk setiap pengguna.

Dalam ruang lingkup APD, pekerjaan meliputi pembuatan mekanisme penyampaian data yang efektif, menentukan makna yang penting bagi setiap pengguna, menentukan periode perbaruan data yang diperlukan, menemukan data yang sesuai, dan menggunakan analisis, pengelompokan, dan visualisasi yang tepat.

Bidang ilmu terkait dengan APD termasuk analisis bisnis, perbaikan proses bisnis, visualisasi data, arsitektur informasi, arsitektur solusi, dan analisis statistik. Semua bidang ini berkontribusi pada pemahaman dan penerapan APD dalam konteks bisnis dan organisasi.

Dalam prakteknya, APD mempertimbangkan berbagai elemen dalam desain grafis atau pengguna, termasuk pemilihan lokasi, warna, dan elemen grafis lainnya, dengan tujuan mengomunikasikan makna, pengaruh, dan informasi yang bermanfaat bagi pengguna.

Pemahaman yang mendalam tentang APD membantu organisasi dalam menyajikan data dengan jelas, mudah dimengerti, dan mempengaruhi pengambilan keputusan yang efektif. Dengan memanfaatkan keahlian APD, sebuah organisasi dapat meningkatkan kinerja bisnisnya melalui penggunaan data yang lebih cerdas dan efisien.

Disadur dari: id.wikipedia.org